在當今數據驅動的時代,企業面臨著海量、高速、多樣化的數據洪流。如何實時、高效地處理這些流式數據,從中提取價值,成為了核心挑戰。Apache Kafka,作為一個分布式流處理平臺,憑借其高吞吐、可擴展、持久化的特性,已成為構建實時數據管道和流式應用的事實標準。本文將為您提供一份Kafka實戰指引,助您駕馭實時海量流式數據處理。

一、理解Kafka的核心架構

Kafka的設計圍繞幾個核心概念展開,理解它們是實戰的第一步。

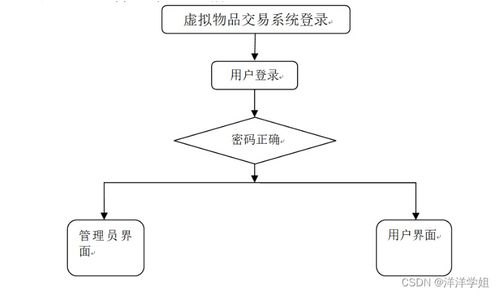

- 生產者(Producer)與消費者(Consumer):生產者將數據發布到Kafka的特定主題(Topic);消費者則從主題訂閱并拉取數據進行處理。這種解耦模式是實現異步、靈活數據處理的基礎。

- 主題(Topic)與分區(Partition):主題是數據發布的類別或訂閱源名稱。一個主題可以被分為多個分區,分區是Kafka實現水平擴展和并行處理的基本單元。數據被追加寫入分區,并分配一個唯一的偏移量(Offset)。

- 代理(Broker)與集群(Cluster):一個Kafka服務器稱為Broker。多個Broker組成一個集群,共同提供高可用性和負載均衡服務。每個分區會在多個Broker上存儲副本(Replica),確保數據安全。

- ZooKeeper的協調作用:在較新版本中(Kafka 2.8+開始支持KRaft模式以擺脫ZooKeeper),ZooKeeper通常用于管理集群元數據、領導者選舉和配置信息,是集群穩定運行的“大腦”。

二、構建高吞吐數據管道:實戰配置要點

要讓Kafka處理海量數據,合理的配置和架構設計至關重要。

- 生產者端優化:

- 批量發送(Batch):配置

batch.size和linger.ms參數,讓生產者在發送前積累小批消息,減少網絡請求次數,大幅提升吞吐量。

- 壓縮(Compression):啟用消息壓縮(如snappy, lz4, gzip),可以有效減少網絡傳輸和磁盤存儲的開銷。

- 確認機制(Acks):根據業務對數據可靠性的要求,選擇

acks=0(最高吞吐,無確認)、acks=1(領導者確認,平衡)或acks=all(所有副本確認,最可靠)。

- 消費者端優化:

- 消費者組(Consumer Group):利用消費者組實現負載均衡和并行消費。組內每個消費者負責消費一個或多個分區,分區數是消費者并行度的上限。

- 偏移量提交:理解自動提交與手動提交的優劣。對于精確一次性處理(Exactly-Once)場景,需仔細管理偏移量提交與業務處理的原子性。

- 拉取參數:調整

fetch.min.bytes和fetch.max.wait.ms,可以在延遲和吞吐量之間取得平衡。

- Broker與主題規劃:

- 分區數規劃:分區數決定了主題的最大并行度。需根據目標吞吐量和消費者數量預估,并預留擴展空間,但分區并非越多越好,過多會影響可用性和延遲。

- 副本因子(Replication Factor):通常設置為3,以確保在單個節點甚至機架故障時數據不丟失、服務不中斷。

- 日志保留策略:根據數據價值設置

retention.ms(時間)或retention.bytes(大小),控制磁盤空間占用。

三、進階:使用Kafka Streams與KSQL進行流式數據處理

Kafka不僅是消息隊列,其內置的流處理庫Kafka Streams和KSQL(現為kafkaDB中的ksqlDB)讓實時數據處理變得更為強大和便捷。

- Kafka Streams:一個用于構建實時流處理應用的Java庫。它直接集成在應用中,無需單獨的處理集群。您可以輕松實現:

- 數據轉換(Map/Filter):對流中的每條記錄進行清洗或變形。

- 聚合(Aggregation):基于時間窗口或會話窗口進行計數、求和、求平均等操作。

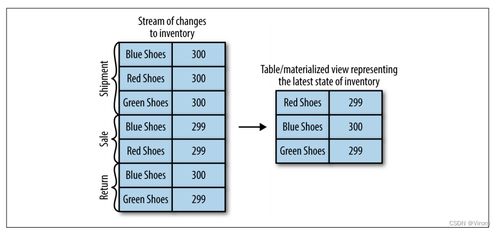

- 連接(Join):將兩個流(或流與表)基于鍵進行關聯,如同在數據庫中進行表連接。

- ksqlDB:為Kafka提供的流式SQL引擎。您可以使用熟悉的SQL語句來定義流(Stream)和表(Table),并執行持續的查詢,極大降低了實時應用開發門檻。例如,

CREATE STREAM pageviews WITH (KAFKA<em>TOPIC='pageviews', VALUE</em>FORMAT='JSON');即可定義一個流,隨后便可使用SQL進行過濾、聚合等操作。

四、實戰場景與運維監控

- 典型應用場景:

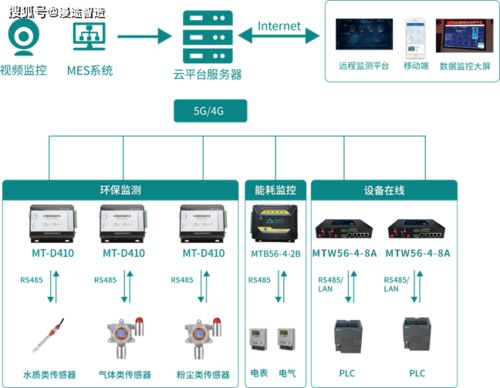

- 實時監控與報警:將應用日志、系統指標發送至Kafka,由下游消費者實時分析并觸發報警。

- 用戶活動追蹤:網站或APP的用戶點擊流實時接入Kafka,用于實時推薦、個性化體驗或欺詐檢測。

- 微服務間通信:作為后端服務的事件總線,解耦服務,實現最終一致性。

- 數據湖/倉的實時攝入:作為傳統批處理ETL的補充,將實時數據流持續注入數據湖(如Iceberg/Hudi)或數據倉庫。

- 運維與監控:

- 關鍵指標:密切關注集群吞吐量(生產/消費)、請求延遲、網絡流量、磁盤使用率、控制器(Controller)狀態以及副本同步滯后(ISR)情況。

- 工具:利用Kafka自帶的

kafka-topics.sh、kafka-consumer-groups.sh等腳本進行日常管理。集成JMX監控,并使用Prometheus+Grafana或Confluent Control Center等工具進行可視化監控和告警。

###

掌握Kafka實戰,意味著您不僅能夠搭建一個高性能的數據管道,更能構建起一個響應迅捷、洞察深刻的實時數據處理系統。從核心概念理解,到生產環境調優,再到利用Kafka生態進行流式計算,每一步都需要結合具體業務需求進行權衡和設計。隨著技術的演進,Kafka正在與云原生、Serverless等趨勢深度融合,持續鞏固其作為實時數據流處理基石的領導地位。開始您的Kafka實戰之旅,讓數據流動起來,創造即時價值。